Em ano de eleições, há uma tensão dentro do TSE (Tribunal Superior Eleitoral) sobre os impactos que podem ser causados por ferramentas de IA (inteligência artificial). A disseminação de fake news e deepfake no pleito é a principal das preocupações.

A presidente do TSE, ministra Cármen Lúcia, sabe do risco, sobretudo pela capacidade da IA em manipular a vontade do eleitor. “A tecnologia não é boa ou ruim em si, mas o mau uso pode contaminar eleições”, afirmou em 27 de janeiro, em seminário sobre desinformação. Embora o diagnóstico seja claro, o desafio brasileiro reside na prática.

Na comparação internacional, o Brasil foi um dos pioneiros que traduziram preocupações sobre IA diretamente em regras eleitorais. Mas especialistas alertam que o efeito real dessas normas dependerá da capacidade institucional de aplicá-las. Nesse sentido, o país vive uma dicotomia: tem leis avançadas, mas braços técnicos ainda em formação.

“O TSE se antecipou ao cenário de ‘bagunça’ normativa ao observar experiências internacionais, como as eleições na Índia, e buscou garantir uma estabilidade normativa mínima antes que o uso dessa tecnologia gerasse caos no pleito”, disse João Archegas, coordenador de Direito e Tecnologia do ITS Rio, ao Poder360.

Archegas, no entanto, duvida da capacidade institucional do país para lidar com o desafio. “A Justiça eleitoral não tem dimensão do problema que vem pela frente. Quando a maré começar a subir, vai ser um toque para virar tsunami.”

O próprio TSE reconhece ainda não ter protocolos bem estabelecidos para enfrentar a tecnologia no cotidiano dos processos eleitorais. Segundo o chefe da seção de Defesa Cibernética do tribunal, Marcelo Carneiro, a identificação de conteúdos falsos produzidos por IA “ainda exige amadurecimento técnico” e cooperação com plataformas digitais.

Para entender como o Brasil chegou a esse pioneirismo, é preciso olhar para o desenrolar do assunto na Europa.

A União Europeia está nas fases finais para a implementação do EU AI Act, uma das regulações mais avançadas do mundo para sistemas de inteligência artificial. O bloco adotou uma abordagem baseada em risco, com exigências mais rígidas para aplicações consideradas de alto impacto e sanções que podem chegar a € 35 milhões ou 7% do faturamento global.

A regulamentação europeia classifica níveis de risco de uso de IA. Um dos exemplos de “alto risco” estabelecidos é o de processos democráticos (como influenciar eleições). Para combater esse risco, existem algumas medidas, semelhantes às do Brasil, aplicadas na UE. Por exemplo, a obrigação de partidos de colocar uma marca d’água ou algum indicativo quando utiliza IA para gerar imagens.

A arquitetura europeia virou referência por estabelecer um modelo que tenta equilibrar inovação e proteção de direitos fundamentais. O problema é que o EU AI Act é uma norma ampla: cria obrigações de transparência e governança, mas não estabelece regras específicas para propaganda eleitoral, como a resolução do TSE, que avançou em pormenores no Brasil.

Ainda assim, a influência da UE sobre o Brasil é direta. O PL 2338 de 2023, que cria o marco legal brasileiro da IA, também adota classificação de riscos e prevê penalidades de até R$ 50 milhões ou 2% do faturamento. Para João Archegas, o texto, em discussão na Câmara dos Deputados, foi “quase uma cópia da regulação europeia” nesse desenho técnico. A expectativa é que a Câmara vote a proposta até junho.

O contraste entre Brasil e UE é que o país já avançou com regras eleitorais específicas, enquanto a Europa ainda depende de guias, interpretações e aplicações indiretas de uma lei geral para tentar conter abusos em campanhas.

Em fevereiro de 2024, a Justiça Eleitoral brasileira incluiu dispositivos que estabelecem proibição expressa de deepfakes em campanhas, classificados como abuso de comunicação; rotulagem obrigatória de conteúdos gerados por IA; e limitação ao uso de chatbots, permitindo a automação para atendimento, mas sem se passar por pessoa real ou pelo próprio candidato. Vale lembrar que, a depender do caso, o conteúdo falso leva à cassação do mandato.

“Ficam proibidos aqueles que veiculem informação enganosa que possa prejudicar o candidato oposto ou se beneficiar artificialmente. E que tenha potencial de desequilibrar o jogo eleitoral. É diferente de usar IA para aperfeiçoar a parte técnica de um vídeo, como a qualidade do som”, disse Maranhão.

O país discute agora diretrizes para as eleições deste ano. O ministro Nunes Marques, futuro presidente do TSE, assinou minutas com resoluções que versam sobre temas como pesquisas eleitorais, registro de candidaturas, ilícitos eleitorais e propagandas.

Os textos ainda passarão por audiências públicas, que começam em 3 de fevereiro, e podem sofrer alterações a partir de contribuições de entidades da sociedade civil, associações, partidos políticos, empresas e demais interessados no debate.

Enquanto Brasil e UE buscam regras institucionais, o resto do mundo opera em lógicas distintas. Nos Estados Unidos, a situação é incerta. Houve uma tentativa em 2023 de regulação de IA com a Ordem Executiva do ex-presidente, Joe Biden, mas Trump deixou de lado. O país combina leis estaduais e ordens executivas federais em disputa, criando um cenário fragmentado, que dá margem para respostas diferentes em cada Estado e amplia a insegurança jurídica.

“Existe um incentivo nos Estados Unidos para adotar padrões técnicos e treinamentos no setor privado, mas não existem proibições e sanções”, explica a professora de direito da USP, Cristina Godoy.

Na administração Trump, na esfera federal, a linha é não regular para não trazer qualquer embaraço ao avanço da tecnologia. Porém, nos estados existem regulações. A agência reguladora de saúde e a agência reguladora do setor financeiro já têm regulamentos para a IA, por exemplo.

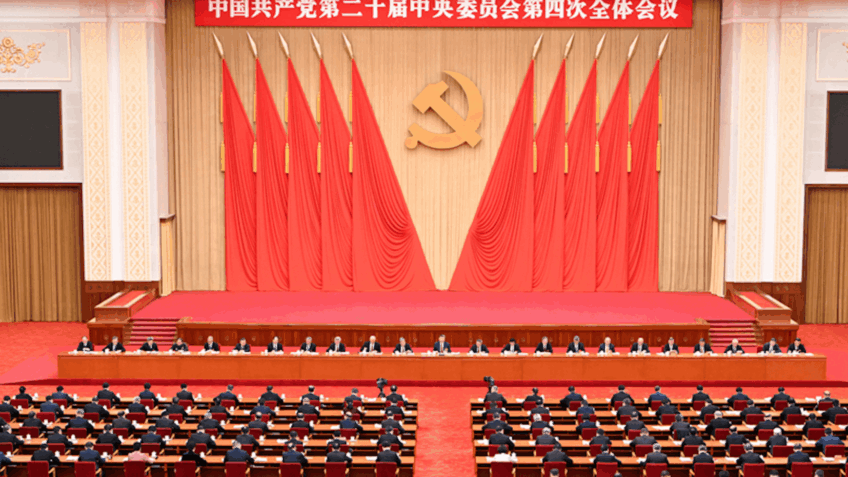

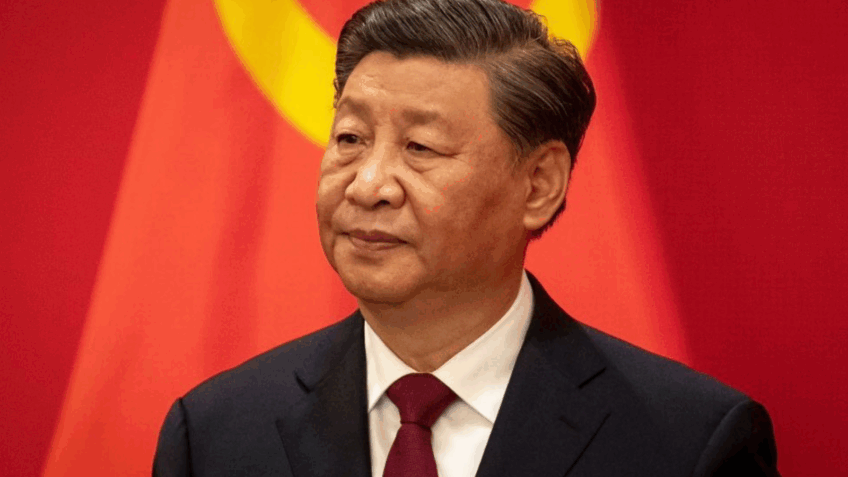

Já na China, a abordagem é oposta. O país reforçou um modelo de controle estatal sobre algoritmos e conteúdos, com auditorias e exigências de marcações em mídias sintéticas, como marcas d’água e metadados criptografados. O modelo apoia-se na ideia de estabilidade social e supervisão vertical, em vez de autorregulação das plataformas ou debate judicial descentralizado.

“Na China, as regras seguem sistemas de IA por grandes empresas, que direcionam a indústria dessa forma, com parcerias entre Estado e indústria”, resume Juliano Maranhão.

Em 2025, o Japão publicou uma legislação de IA voltada para estímulo ao investimento e que valoriza mais os parâmetros de governança de instituições internacionais como o ISO (sigla em inglês para Organização Internacional para a Padronização), mais voltada para uma autorregulação das indústrias.